Открытые облака больше, чем когда-либо. В то время как большинство компаний сегодня используют единый государственный облачный провайдер в дополнение к своей локальной среде, исследования показывают, что в ближайшие годы большинство компаний, скорее всего, примут несколько публичных и частных облаков. Фактически, согласно исследованию по правам человека 2018 года, 81% предприятий с 1000 или более сотрудниками имеют стратегию с несколькими облаками, и если вы считаете SaaS, то большинство организаций уже делают много облаков.

Открытые облака позволяют клиентам свободно выбирать, какая комбинация услуг и провайдеров наилучшим образом удовлетворит их потребности с течением времени. Открытые облака позволяют заказчикам эффективно управлять своей инфраструктурой в среде гибридных облаков.

Мы верим в три принципа для открытого облака:

- Open — это возможность забрать приложение и перенести его — туда и обратно, облако или другое облако — в любое время.

- Программное обеспечение с открытым исходным кодом позволяет обеспечить многообразие мысли и непрерывной обратной связи с пользователями.

- Открытые API сохраняют способность каждого строить работу друг друга.

1. Open — это возможность забрать приложение и переместить его

Открытое облако основано на убеждении, что привязка к определенному облаку не должна мешать достижению ваших целей. Открытое облако охватывает идею о том, что способность доставлять ваши приложения на разные облака при использовании общего подхода к разработке и операциям поможет вам в любой момент, независимо от того, какой ваш приоритет зависит от того, насколько эффективно вы используете свои навыки в разных командах или быстро ускоряя инновации. Открытый источник — это инструмент открытых облаков, потому что открытый источник в облаке сохраняет контроль над тем, где вы развертываете свои инвестиции в ИТ. Например, клиенты используют Kubernetes для управления контейнерами и TensorFlow для создания моделей машинного обучения на местах и на нескольких облаках.

2. Программное обеспечение с открытым исходным кодом обеспечивает богатый уровень мысли и непрерывный цикл обратной связи с пользователями

Благодаря непрерывному циклу обратной связи с пользователями программное обеспечение с открытым исходным кодом (OSS) приводит к лучшему программному обеспечению, быстрее и требует значительного времени и инвестиций со стороны людей и компаний, ведущих проекты с открытым исходным кодом. Вот примеры приверженности Google OSS и требуемым различным уровням работы:

- OSS, такой как Android, имеет открытую базу кода, и разработка является исключительной ответственностью одной организации.

- OSS с изменениями, связанными с сообществом, такими как TensorFlow, предполагает координацию между многими компаниями и отдельными лицами.

- OSS с общинной стратегией, например сотрудничество с Linux Foundation и сообществом Kubernetes, предполагает совместную работу, принятие решений и принятие консенсуса в отношении контроля.

Открытый источник настолько важен для Google, что мы называем его дважды в нашей корпоративной философии, и мы призываем сотрудников, а на самом деле всех разработчиков, взаимодействовать с открытым исходным кодом.

Используя BigQuery для анализа данных GHarchive.org, мы обнаружили, что в 2017 году более 5500 гуглеров представили код почти в 26 000 репозиториев, создали более 215 000 запросов на тягу и общались с бесчисленными сообществами почти через 450 000 комментариев. Сравнительный анализ вклада Google в открытый исходный код обеспечивает полезную относительную позицию ведущих компаний в открытом источнике на основе нормализованных данных.

Googlers активно участвуют в популярных проектах, о которых вы, возможно, слышали, включая Linux, LLVM, Samba и Git.

Регулярно открытые внутренние проекты Google

Лучшие проекты, инициированные Google, включают:

- Кубернетес — контейнерная оркестровка (github)

- TensorFlow — # 1 репозиторий для машинного обучения на github

- BBR алгоритм управления перегрузкой — ваш Интернет только быстрее (github)

- Open compute project rack — эффективный дата-центр для всех (pdf)

- gRPC — высокопроизводительная инфраструктура RPC (github)

- Bazel — система непрерывной интеграции (github)

- VP9 — формат видеокодирования без роялти (проект)

- Хром — самый популярный браузер (github)

- Android — самая популярная операционная система для смартфонов (веб-сайт)

- Golang — разработка простого, эффективного и надежного программного обеспечения в масштабе (github)

- V8 — высокопроизводительный движок JavaScript (github)

3. Откройте API-интерфейсы, чтобы сохранить способность каждого строить работу друг друга

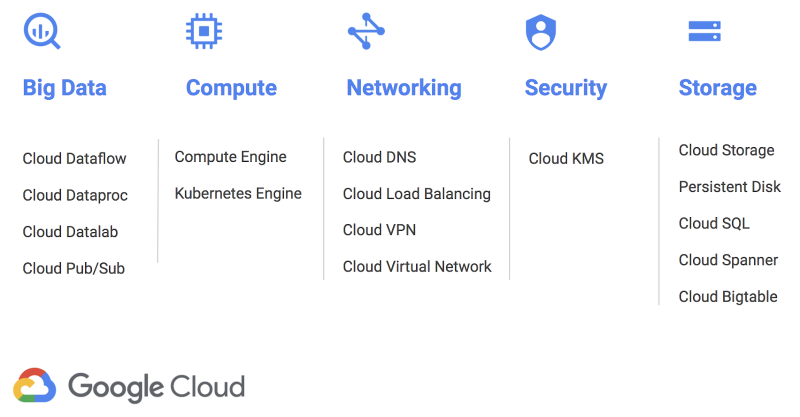

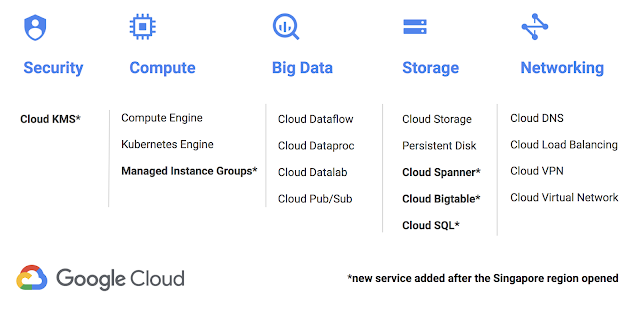

Открытые API-интерфейсы сохраняют способность каждого строить работу друг друга, улучшая программное обеспечение итеративно и совместно. Открытые API позволяют компаниям и отдельным разработчикам по желанию изменять поставщиков услуг. Рецензируемые исследования показывают, что открытые API-интерфейсы ускоряют инновации во всей отрасли и в любой конкретной экосистеме. Открытые API-интерфейсы зависят от права повторного использования установленных API-интерфейсов, создавая независимые, но совместимые реализации. Google стремится поддерживать открытые API через наше участие в Open API Initiative, участие в спецификации Open API, поддержку gRPC, благодаря совместимости с Cloud Bigtable с API-интерфейсом HBase, Cloud Spanner и BigQuery с SQL: 2011 (с расширениями) и совместимость с облачным хранилищем с общими API.

Создайте открытое облако с нами

Если вы верите в открытое облако, как мы, мы будем рады вашему участию. Вы можете помочь